拨开数据迷雾 大数据的深度思考与认知重构

引言:当数据成为新时代的石油

我们正身处一个被数据淹没的时代。据国际数据公司(IDC)预测,到2025年全球数据总量将达到175ZB(泽字节),相当于如果将这些数据全部存储在蓝光光盘上,光盘堆叠起来的高度足以往返月球23次。海量数据本身并不等同于价值——正如原油需要提炼才能成为汽油,原始数据也需要经过复杂的处理、分析与解读,才能转化为真正的洞察力。

一、超越表象:大数据的三个认知维度

1. 从“大”到“深”:规模之外的价值密度

传统认知中,“大数据”往往与“海量”画等号。但实际上,大数据的关键特征远不止规模(Volume),还包括多样性(Variety)、速度(Velocity)和最重要的——价值密度(Value)。随着数据采集成本的降低,我们收集的数据中真正有价值的信息比例正在急剧下降。例如,一架波音787每飞行一小时产生约40TB数据,但其中可能只有不到1%的数据对预测性维护具有关键意义。

2. 从“知”到“智”:数据处理的三重境界

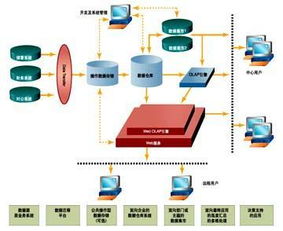

数据处理服务正在经历从信息化到智能化的跃迁:

- 基础层:数据清洗、整合、存储,解决“数据可用”问题

- 分析层:统计分析、机器学习,实现“数据可知”

- 洞察层:模式识别、因果推断、决策支持,达成“数据可智”

真正的价值创造发生在第三层,即从相关性分析走向因果推断,从描述过去转向预测未来。

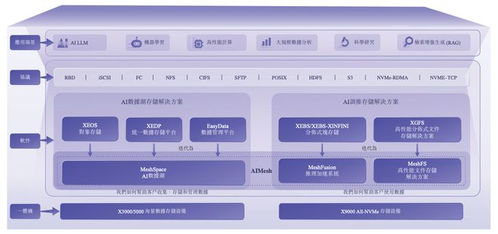

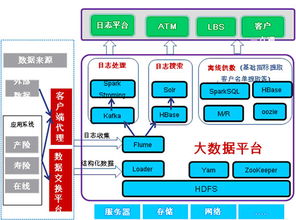

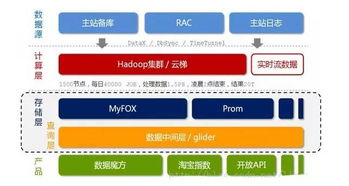

3. 从“存”到“流”:存储范式的根本转变

传统数据存储如数据仓库,建立在“数据静止”的假设上。而现代数据存储支持服务必须应对“数据永动”的现实——物联网设备每秒产生数百万个读数,社交媒体每时每刻都在生成新的内容。因此,流式处理架构和实时数据湖正在取代批处理模式,使得数据能够在产生的同时就被处理和分析。

二、基础设施革命:数据处理与存储的支撑体系

1. 云原生数据栈的崛起

传统企业数据中心正在被云原生架构重构。现代数据处理服务呈现出三个特征:

- 弹性可扩展:根据负载动态调整计算和存储资源

- 服务化:从基础设施即服务(IaaS)到数据即服务(DaaS)的演进

- 多云融合:避免供应商锁定,实现数据在不同云平台间的自由流动

2. 存储介质的技术演进

从机械硬盘到固态硬盘,再到正在兴起的存储级内存(SCM)和DNA存储技术,存储介质的发展使得数据访问速度呈指数级提升。更值得关注的是,存储与计算的界限正在模糊——以计算存储一体化为代表的新架构,让数据在存储位置就能完成初步处理,大幅减少数据移动带来的延迟和成本。

3. 数据治理的现代化转型

随着数据隐私法规(如GDPR、CCPA)的完善和伦理问题的凸显,数据治理已成为数据处理服务的核心组成部分。现代数据治理包括:

- 数据血缘追踪:完整记录数据从产生到消费的全链条

- 隐私增强技术:差分隐私、联邦学习等保护个体隐私

- 伦理框架:确保算法公平性、可解释性和问责制

三、范式转变:重新思考大数据应用的底层逻辑

1. 从“大数据”到“好数据”

数据质量比数据数量更为关键。研究表明,数据科学家80%的时间花在数据准备和清洗上。因此,现代数据处理服务正在将数据质量管控前移——在数据采集阶段就建立质量控制机制,而非事后补救。

2. 从“中心化”到“边缘-云协同”

物联网的普及催生了边缘计算的兴起。在自动驾驶、工业互联网等场景中,数据需要在产生地附近进行实时处理,仅将聚合结果或异常数据上传到云端。这种边缘-云协同架构不仅降低延迟和带宽成本,也增强了系统的可靠性和隐私保护。

3. 从“通用计算”到“领域专用架构”

通用处理器(CPU)已难以满足特定数据处理任务的需求。领域专用架构(DSA)如谷歌的TPU(张量处理单元)、AWS的Inferentia(推理芯片)等,针对机器学习等特定工作负载优化,能效比和性能比通用芯片高出数个量级。

四、未来展望:数据智能时代的挑战与机遇

1. 技术融合催生新范式

量子计算与经典计算的结合可能彻底改变复杂优化问题的求解方式;神经拟态计算模仿人脑结构,有望实现更高效的模式识别;区块链技术为数据确权和可信共享提供新路径。这些技术的融合将催生下一代数据处理范式。

2. 人机协作的再平衡

随着自动化机器学习(AutoML)和低代码/无代码平台的成熟,数据分析的门槛正在降低。但这不意味着人类角色的弱化,而是从“数据操作者”向“问题定义者”和“价值判断者”的转型。人类在伦理考量、创造性思维和跨领域知识整合方面的优势,依然是机器无法替代的。

3. 可持续发展成为硬约束

数据中心的能耗问题日益突出——全球数据中心耗电量已占全球总用电量的约1%。绿色数据处理技术,如利用自然冷却、可再生能源供电、提高硬件能效等,不仅是企业社会责任,也将成为成本竞争的关键因素。

在数据洪流中保持清醒

大数据不仅仅是技术概念,更是认知框架。真正读懂大数据,意味着我们能够:

- 区分数据噪声与信号,在信息过载中保持焦点

- 理解数据处理链条的每个环节,知其然更知其所以然

- 平衡技术创新与伦理约束,在效率与公平间寻找最佳点

- 将数据思维与领域知识深度融合,避免“锤子找钉子”的陷阱

大数据的价值不在于我们拥有多少数据,而在于我们能否提出正确的问题,并设计恰当的方法从数据中寻找答案。在这个意义上,数据处理和存储支持服务不仅是技术基础设施,更是组织认知能力和决策智慧的延伸。当技术工具与人类智慧形成良性互动,数据才能真正从负担变为财富,从噪声变为信号,从记录变为洞察。

如若转载,请注明出处:http://www.yuanwangyun.com/product/46.html

更新时间:2026-03-03 11:35:39